[사진=게티이미지뱅크]

SKT가 작년 선보인 한국어 문장생성 인공지능(AI) 모델 'KoGPT2'의 성능을 개선했다. AI가 더 자연스러운 한국어 표현을 할 수 있도록 만드는 데 활용할 전망이다. 정부가 공개한 AI 학습용 데이터를 포함한 40GB 이상의 텍스트를 학습시켰다.

4일 업계에 따르면 최근 SKT는 KoGPT2 모델 2.0 버전을 개발했다. KoGPT2는 테슬라를 창업한 일론 머스크, 페이팔을 창업한 피터 틸 등이 지원해 설립된 민간 AI연구소 '오픈AI'가 개발한 영어문장생성 AI 'GPT-2'의 한국어판이다.

이번에 나온 KoGPT2는 1년 3개월전 나온 모델의 업그레이드판이다. 단어 몇 개가 주어지면 그 뒤에 자연스럽게 이어질 수 있는 단어를 추론해서 문장을 이어 나가는 AI다. 영어 텍스트로 학습된 원본 GPT-2보다 한국어 문장을 더 잘 만들어낸다.

SKT 연구진 설명에 따르면 KoGPT2 2.0 버전은 문맥을 유지하면서 최대한 많은 문장을 출력할 수 있게 만들어졌다. 의미적 연관성을 갖는 문단을 쓸 수 있다는 얘기다. 이는 기존 모델이 문장 기준 생성만 가능했던 약점을 보완한 것이다.

이를 위해 SKT 연구진은 기존 두 배 이상 크기(40GB)의 학습 데이터셋을 사용했고, 모델이 학습을 위해 사용한 사전(일종의 '단어장')에 이모티콘과 이모지 등을 포함한 5만1200개의 토큰(데이터값)을 추가했다.

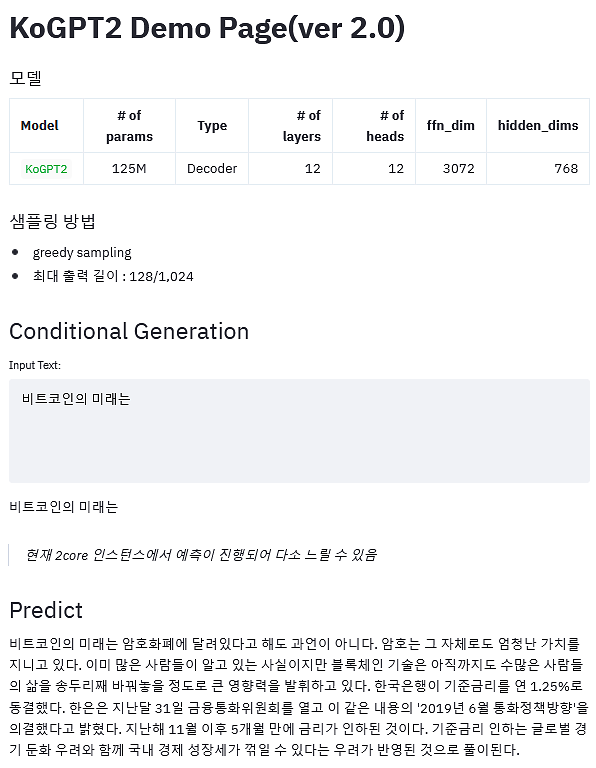

지난 3일부터 온라인 소프트웨어 개발 협업 서비스 '깃허브'에 KoGPT2 2.0 버전 소개와 데모 웹페이지가 공개됐다. 깃허브 소갯말에 따르면 KoGPT2 2.0 버전의 NSMC 측정치는 93.3점, KorSTS 측정치는 78.4점, PPL 측정치는 24.6점이다.

NSMC는 네이버 영화 리뷰 데이터를 활용한 감정분석 분류 작업으로 언어처리 AI 모델의 성능을 평가하는 지표다. 2.0 버전의 점수 93.3점은 이 모델의 '감정 분석' 분류 정확도가 93.3%라는 뜻으로, 기존(1.0버전) 89.9% 대비 향상됐음을 보여 준다.

PPL은 ''혼잡도(Perplexity)'인데, 이 값은 1.0 버전(45.4)보다 45.8% 감소했다. 이 수치는 모델이 문장을 생성하면서 평균적으로 몇 개의 단어를 후보군으로 놓고 다음 단어를 선택할지를 뜻한다. 즉 숫자가 줄어든만큼 성능은 더 향상됐다는 얘기다.

신모델의 성능이 모든 면에서 향상된건 아니다. AI 모델의 자연어이해(NLU) 성능 지표 중 하나로 두 문장 간 의미의 유사도를 측정하는 KorSTS 스피어만상관계수가 KoGPT2 1.0 버전의 80.1보다 소폭 하락했다.

KoGPT2 2.0 버전의 소스코드는 아직 공개되지 않았다. 대신 이 모델을 사용해볼 수 있는 시연용 웹페이지가 개설돼 있다. 웹페이지에 몇 개의 단어를 입력하면 여러 개의 문장으로 구성된 문단을 완성시켜 주는 기능을 체험해 볼 수 있다.

KoGPT2 2.0의 향상된 성능에도 모델 크기 자체는 종전과 비슷한 수준이 유지돼 눈길을 끈다. 오리지널 GPT2는 최다 15억개의 파라미터를 계산해 작동하는 거대 모델이었다. KoGPT2의 파라미터 수는 그 10분의1 수준을 유지하고 있다.

AI 모델의 파라미터 수가 많을수록 대량의 연산을 통해 높은 정확도와 성능을 보여주는 경향이 있지만, 그만큼 경제적으로 활용하기는 어려워진다. AI를 실용화하려면 제한된 연산 자원 내에서 의미있는 성능을 얻을 수 있어야 한다.

SKT KoGPT2 2.0 버전 데모 웹사이트. [자료=SKT 웹사이트]

![[포토] 우원식 의장에게 항의하는 국민의힘](https://image.ajunews.com/content/image/2024/12/27/20241227165203327755_518_323.jpg)

![[포토] 본회의장 나와 규탄대회 연 국민의힘](https://image.ajunews.com/content/image/2024/12/27/20241227165050901400_518_323.jpg)

![[포토] 헌법재판소 심판정 나서는 배진한 변호사](https://image.ajunews.com/content/image/2024/12/27/20241227165355871140_518_323.jpg)

![[포토] 다이빙 신임 주한 中대사, 전략적 협력 동반자관계 발전시킬 것](https://image.ajunews.com/content/image/2024/12/27/20241227140309624240_518_323.jpg)