소형언어모델은 그간 주로 AI 후발 기업 혹은 스타트업들이 많이 개발해 왔다. LLM에 비해 언어모델을 구축하는 데 드는 시간과 비용이 훨씬 적은 데다 메타 '라마' 등 소형언어모델 개발에 토대가 될 수 있는 오픈소스 모델도 잘 갖춰졌기 때문이다. 초반 빅테크 기업들이 이끌던 생성 AI 시장에 수많은 스타트업들이 가세하는 데 큰 역할을 했다. 이런 가운데 최근 구글·마이크로소프트(MS)·앤스로픽·네이버 등 이미 LLM을 만들었거나 관련 업체와 긴밀한 협력 체제를 갖춘 기업들도 소형언어모델 출시에 열을 올리며 시장 분위기가 뜨거워지고 있다.

구글·MS부터 네이버까지···소형언어모델 줄줄이 출시

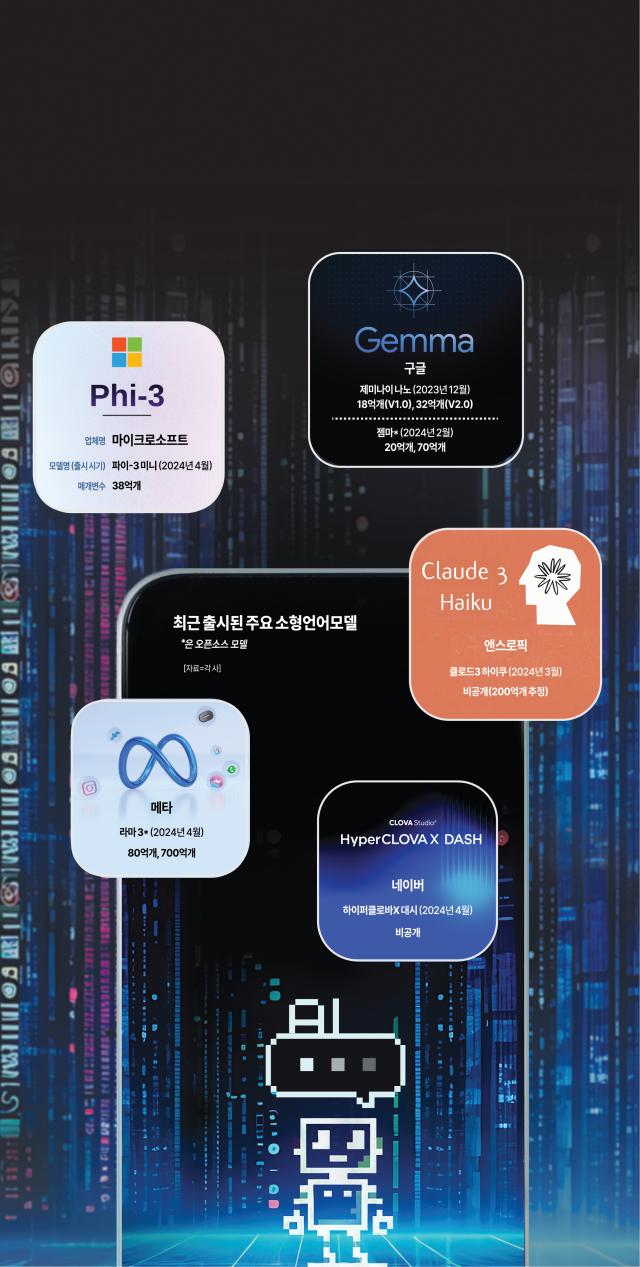

29일 업계에 따르면 최근 구글 '제미나이 나노' '젬마', MS '파이(Phi)-3 미니', 앤스로픽 '하이쿠', 메타 '라마3' 등 소형언어모델들이 잇따라 출시됐다. 이들은 공통적으로 매개변수가 1000억개 미만이지만 경량화를 통한 응답 속도 향상과 입력 데이터 최적화 등으로 LLM 못지않은 효율을 낼 수 있다는 점을 강조한다.

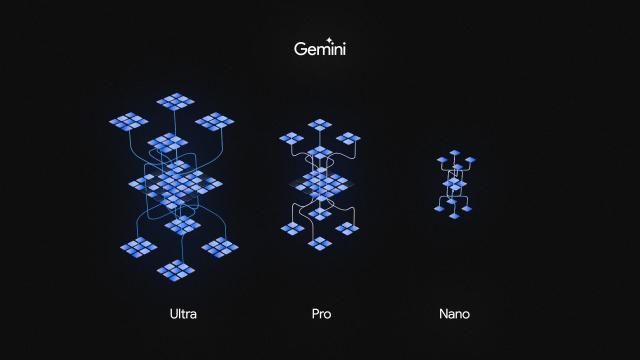

'제미나이'로 LLM 시장에서 'GPT4' 오픈AI의 강력한 경쟁자로 꼽히는 구글은 소형언어모델도 선보였다. 지난해 12월 새로운 AI 모델인 '제미나이'를 선보이면서 함께 내놓은 '제미나이 나노'다. 매개변수는 32억5000만개(2.0 버전 기준)로 작은 편이다. 제미나이 나노에 대해 구글은 '온디바이스(On-device)' 작업에 가장 효율적인 모델이라고 소개했다. 스마트폰·노트북 등 다양한 기기에서도 자체적으로 구동할 수 있는 경량화된 AI라는 것이다. 이미 구글 스마트폰인 '픽셀8 프로'에 제미나이 나노가 탑재된 바 있다.

MS는 파이-3 미니의 강점에 대해 특정 분야 작업을 적은 비용으로 수행 가능하다고 소개했다. 특히 비슷한 성능을 지닌 다른 모델 대비 비용이 10분의 1 수준이라며 가격 대비 성능이 뛰어나다는 점을 강조했다. 조만간 순차적으로 파이-3 스몰과 파이-3 미디엄도 내놓겠다는 계획이다. 각각 매개변수 70억개·140억개로 파이-3 미니보다는 크지만 역시 소형언어모델로 분류된다. MS는 오픈AI와 협력하는 것과는 별개로 지속적으로 소형언어모델을 내놓는 모습이다.

최근 GPT4를 앞서는 성능을 낸 '클로드3'로 전 세계 시선을 끈 앤스로픽 역시 클로드3 경량화 모델인 '하이쿠'를 지난달 내놓았다. 클로드3는 학습량에 따라 '오푸스' '소네트' '하이쿠' 등 세 가지 버전으로 출시됐는데 하이쿠는 이 중 가장 작은 모델이다. 앤스로픽은 하이쿠의 장점으로 싼 비용과 빠른 작동 속도를 내세웠다. 회사 측에 따르면 하이쿠의 데이터 입출력 수수료는 구글 '제미나이' 1.0 버전 등 경쟁사 LLM보다 조금 더 저렴하며 작동 속도는 보다 매개변수가 큰 클로드3의 다른 모델보다 약 3배 빠르다.

한편 메타와 미스트랄AI 등 오픈소스 진영에서도 계속해서 새로운 소형언어모델을 출시하고 있다. 메타 '라마3', 미스트랄AI의 '미스트랄 7B' 등이 대표적이다. 이 중 지난 19일 출시된 라마3는 8B(매개변수 80억개) 모델과 70B(매개변수 700억개) 모델을 나란히 공개했는데 최신 LLM인 오픈AI 'GPT4'에 크게 뒤지지 않는 성능을 구사한다는 평가다. 구글 역시 '제미나이 나노'와 별개로 오픈소스 소형언어모델인 '젬마'를 최근 공개하며 눈길을 끌었다. 온디바이스 AI에 초점을 맞춘 모델이다.

오픈소스 모델 특성상 누구에게나 소프트웨어의 주요 코드 등이 공개되고, 수정·배포도 자유롭게 가능하다. 이 때문에 수많은 AI 스타트업들이 파인튜닝(미세조정)을 통해 필요에 따라 자체적인 소형언어모델을 개발할 수 있게 되면서 AI 생태계 전반에도 긍정적인 영향을 미친다는 평가다.

빅테크도 주목하는 소형언어모델···이유는

소형언어모델의 성장세는 시장조사업체 조사에서도 잘 드러난다. 미국 시장조사업체 밸류에이츠 리포트가 올해 발간한 보고서에 따르면 2022년 51억8000만 달러였던 소형언어모델(매개변수 수억~수십억 개 기준) 시장 규모는 2029년 171억8000만 달러로 커져 연평균 17.8% 성장할 전망이다.

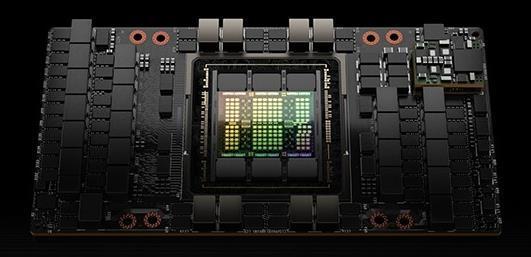

이 같은 빅테크 기업들의 소형언어모델 출시는 자연스러운 수순이라고 업계에서는 평가한다. 가장 큰 이유는 LLM을 구동하는 데 들어가는 막대한 비용 때문이다. 우선 LLM을 지속적으로 구동하려면 데이터 연산을 위한 고성능 서버용 그래픽처리장치(GPU)가 적어도 수천 대 필요한데, 대표적인 서버용 GPU인 엔비디아 'H100' 가격은 대당 최소 5000만원에 달한다. GPU가 원활하게 공급되는 데도 한계가 있어 수요에 따라 가격은 더 오르기도 한다.

비용 문제는 챗봇 등 생성 AI를 활용한 서비스를 제공하고자 하는 수요 기업들에도 적용된다. 일반적으로 LLM 기반 API를 활용할 때 토큰(token·말뭉치)당 비용을 부과하게 되는데, 그렇기 때문에 해당 AI 서비스를 이용자들이 많이 쓸수록 서비스 제공업체에 돌아가는 비용은 더욱 커진다. 생성 AI 시장이 점차 성장하면서 토큰당 가격은 점진적으로 줄어드는 추세지만 여전히 챗GPT 등 LLM 기반 API를 그대로 활용하기에는 부담이 따를 수 있다. 상대적으로 저렴한 소형언어모델로 시선을 돌릴 수 있는 요인이다.

최병호 고려대 인공지능연구소 교수는 "빅테크로서는 LLM을 구동하면서 과도한 비용이 계속해서 들어가는 것이 고민거리고, 비용을 줄이면서도 성능은 유지하거나 더 좋게 해야 하는데 이 부분이 아주 큰 도전 과제"라며 "이를 위해 소형언어모델을 통해 언어모델을 보다 경량화하려는 시도가 많아지고 있는데, 향후 스마트폰·로봇 등 다양한 산업 생태계에서 AI가 본격적으로 활용될 수 있는 만큼 기업들이 전략적으로 움직이고 있는 것"이라고 짚었다.

소형언어모델이 용도와 분야를 특화해서 사용하면 LLM보다 나은 가성비(가격 대비 성능)를 보여줄 수 있다는 점도 작용했다. 대표적으로 올해 시장이 열리고 있는 '온디바이스 AI'가 꼽힌다. 스마트폰, 노트북 등 기기에 소형언어모델을 탑재해 기기 내에서 AI 관련 다양한 기능을 실행할 수 있다는 점이 강점이다. 장기적으로는 로봇, 자동차 등에도 AI를 장착함으로써 새로운 시장을 개척하는 역할도 가능하다. LLM을 그대로 탑재하면 엄청난 양의 연산 등을 기기가 자체적으로 감당할 수 없는 만큼 온디바이스 AI 구현에는 소형언어모델이 보다 적합하다는 것이다.

법률·의료·금융 등 특정 분야에서 활용되는 AI 서비스를 구사할 때도 범용 LLM을 그대로 활용하기보다는 해당 분야 데이터를 중점적으로 학습한 소형언어모델을 활용하는 쪽이 효율적이라는 평가다. 특히 전문 분야에서는 LLM의 단점으로 꼽히는 '환각 현상'이 치명적으로 작용하는데, 소형언어모델은 데이터가 특정 분야에 집중된 만큼 여기서 상대적으로 자유로운 편이다.

특히 자체 LLM을 구동 중인 빅테크 기업들은 수많은 데이터를 수집하는 과정에서 이미 데이터 학습 경쟁력을 갖췄고, 빠른 기술 발전 속에 데이터 학습 기법도 발전하고 있기 때문에 이들이 작지만 강한 모델들을 쏟아내고 있다는 설명이다.

하정우 네이버 퓨처AI센터장은 "규모가 큰 언어모델을 만드는 기업들은 기본적으로 데이터를 충분히 확보해 놓기도 했고, 그러한 데이터를 다양한 방식으로 가공함으로써 보다 양질의 데이터를 학습하도록 해 작은 모델로도 강력한 성능을 낼 수 있다"며 "경쟁력 있는 소형언어모델을 통해 운영비도 줄이고 다양한 비즈니스 기회를 만들고자 하는 것"이라고 말했다.

![[슬라이드 포토] 2024 SBS 연기대상 레드카펫을 빛낸 배우들](https://image.ajunews.com/content/image/2024/12/21/20241221223535311348_518_323.jpg)

![[포토] 남태령 넘는 트랙터 상경 농민들](https://image.ajunews.com/content/image/2024/12/21/20241221154214630050_518_323.jpg)

![[포토] 윤대통령 측 석동현 변호사, 서울고검 앞에서 입장 표명](https://image.ajunews.com/content/image/2024/12/19/20241219161112655781_518_323.jpg)

![[포토] 악수하는 이재명 대표와 권성동 원내대표](https://image.ajunews.com/content/image/2024/12/18/20241218150658549939_518_323.jpg)