팻 겔싱어 인텔 최고경영자가 9일(현지시간) 미국 애리조나주 피닉스에서 열린 인텔 비전 행사에서 신형 인공지능 반도체 키노트(기조연설)를 진행했다. [사진=인텔]

인텔이 차세대 인공지능(AI) 반도체 '가우디3(Gaudi-3)'를 공개하며 관련 시장을 사실상 독점하고 있는 엔비디아에 도전장을 냈다. 현재 네이버 등 주요 파트너 기업에 가우디3 샘플칩을 전달한 데 이어 오는 3분기 본격적으로 양산하며 시장 점유율을 확대할 방침이다.

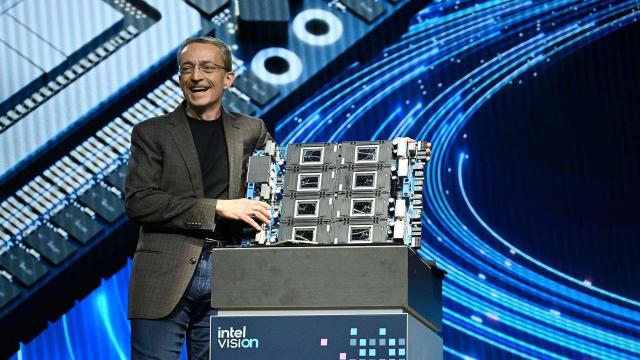

인텔은 9일(현지시간) 미국 애리조나주 피닉스에서 인텔 비전 행사를 열고 전 세대 제품(가우디2)보다 △AI 컴퓨팅 성능은 4배(BF16·저 메모리 16비트 부동 소수점 기준) △메모리 대역폭(시간당 처리할 수 있는 데이터양)은 1.5배 △대형 시스템 구축을 위한 네트워킹 대역폭(I/O)은 2배 강화한 신형 AI 반도체 가우디3를 공개했다.

가우디는 인텔이 지난 2019년 20억 달러(약 2조7000억원)에 인수한 이스라엘의 팹리스 하바나랩스가 개발한 AI 반도체다. 가우디3는 TSMC 5㎚ 공정에서 만들었으며 생성 AI 학습·추론(실행)에 특화한 '행렬곱 엔진'과 '텐서코어(AI 특화)프로세서', 대규모 슈퍼컴퓨터(HPC) 시스템 구성을 위한 '차세대 네트워크 인터페이스 카드'를 탑재했다.

이날 행사에서 인텔은 엔비디아를 노골적으로 저격했다. 인텔에 따르면 가우디3는 엔비디아의 상용 AI 반도체인 H100과 비교해 라마2 7B(매개변수 70억개) 모델 학습속도는 1.5배, 라마2 13B(130억개)는 1.7배, GPT-3 175B(1750억개)는 1.4배 더 빠르다고 주장했다. 추론속도의 경우 라마2 7B와 70B 모델 기준 1.5배 더 우수하며 전력효율성(TDP)도 1.4배 더 향상됐다고 밝혔다. 가우디3 칩당 가격은 아직 공개하지 않았지만, 동급 엔비디아 AI 반도체와 비교해 경쟁력 있게 책정할 것이라고 강조했다.

주장이 사실이라면 엔비디아의 비싼 가격 정책과 공급 제한으로 AI 반도체 수급에 어려움을 겪는 AI·클라우드 기업 사이에서 대안으로 급부상할 전망이다. 실제로 전작인 가우디2는 H100과 비교해 이미지 생성AI 학습·추론 속도가 더 빠르다는 평가를 받은 바 있다.

다만 외신들은 인텔의 발표에 의구심 섞인 시선을 보내고 있다. 미국 IT매체 톰스하드웨어는 "인텔의 가우디3 벤치마크 결과는 과거 제공했던 테스트 구성별 세부 정보 대신 간략한 정보만 제공하고 있어 신뢰성이 낮다"며 "엔비디아가 곧 출시할 신형 AI 반도체 '블랙웰'과 AMD의 AI 반도체 '인스팅트 MI300'과 비교한 데이터도 없다"고 지적했다.

이러한 언론 우려에 신뢰성을 더하는 것이 전작과 큰 변화가 없는 메모리(D램) 성능이다. 가우디3는 전작과 마찬가지로 HBM2E(3세대 고대역폭메모리)를 탑재했다. 칩당 용량을 96GB(기가바이트)에서 128GB로 확장했고 초당 3.7TB(테라바이트)의 대역폭을 제공한다. 하지만 경쟁사가 HBM3(4세대 고대역폭메모리)를 넘어 HBM3E(5세대 고대역폭메모리)를 자사 AI 칩에 속속 채택하는 상황에서 D램 성능이 떨어진다는 지적을 피하기 어렵다. 특히 대규모 생성 AI 학습은 텐서코어와 D램이 끊임없이 대규모 데이터를 주고받아야 하기 때문에 SK하이닉스·삼성전자 등이 만든 신형 HBM이 필수적으로 요구된다는 게 전문가들 지적이다.

인텔은 9일(현지시간) 미국 애리조나주 피닉스에서 인텔 비전 행사를 열고 전 세대 제품(가우디2)보다 △AI 컴퓨팅 성능은 4배(BF16·저 메모리 16비트 부동 소수점 기준) △메모리 대역폭(시간당 처리할 수 있는 데이터양)은 1.5배 △대형 시스템 구축을 위한 네트워킹 대역폭(I/O)은 2배 강화한 신형 AI 반도체 가우디3를 공개했다.

가우디는 인텔이 지난 2019년 20억 달러(약 2조7000억원)에 인수한 이스라엘의 팹리스 하바나랩스가 개발한 AI 반도체다. 가우디3는 TSMC 5㎚ 공정에서 만들었으며 생성 AI 학습·추론(실행)에 특화한 '행렬곱 엔진'과 '텐서코어(AI 특화)프로세서', 대규모 슈퍼컴퓨터(HPC) 시스템 구성을 위한 '차세대 네트워크 인터페이스 카드'를 탑재했다.

이날 행사에서 인텔은 엔비디아를 노골적으로 저격했다. 인텔에 따르면 가우디3는 엔비디아의 상용 AI 반도체인 H100과 비교해 라마2 7B(매개변수 70억개) 모델 학습속도는 1.5배, 라마2 13B(130억개)는 1.7배, GPT-3 175B(1750억개)는 1.4배 더 빠르다고 주장했다. 추론속도의 경우 라마2 7B와 70B 모델 기준 1.5배 더 우수하며 전력효율성(TDP)도 1.4배 더 향상됐다고 밝혔다. 가우디3 칩당 가격은 아직 공개하지 않았지만, 동급 엔비디아 AI 반도체와 비교해 경쟁력 있게 책정할 것이라고 강조했다.

다만 외신들은 인텔의 발표에 의구심 섞인 시선을 보내고 있다. 미국 IT매체 톰스하드웨어는 "인텔의 가우디3 벤치마크 결과는 과거 제공했던 테스트 구성별 세부 정보 대신 간략한 정보만 제공하고 있어 신뢰성이 낮다"며 "엔비디아가 곧 출시할 신형 AI 반도체 '블랙웰'과 AMD의 AI 반도체 '인스팅트 MI300'과 비교한 데이터도 없다"고 지적했다.

이러한 언론 우려에 신뢰성을 더하는 것이 전작과 큰 변화가 없는 메모리(D램) 성능이다. 가우디3는 전작과 마찬가지로 HBM2E(3세대 고대역폭메모리)를 탑재했다. 칩당 용량을 96GB(기가바이트)에서 128GB로 확장했고 초당 3.7TB(테라바이트)의 대역폭을 제공한다. 하지만 경쟁사가 HBM3(4세대 고대역폭메모리)를 넘어 HBM3E(5세대 고대역폭메모리)를 자사 AI 칩에 속속 채택하는 상황에서 D램 성능이 떨어진다는 지적을 피하기 어렵다. 특히 대규모 생성 AI 학습은 텐서코어와 D램이 끊임없이 대규모 데이터를 주고받아야 하기 때문에 SK하이닉스·삼성전자 등이 만든 신형 HBM이 필수적으로 요구된다는 게 전문가들 지적이다.

팻 겔싱어 인텔 최고경영자가 신형 인공지능 반도체 '가우디3'를 공개했다. [사진=인텔]

이점을 의식한 듯 인텔은 글로벌 주요 AI 기업들과 협력하는 '개방형 AI 생태계'를 만들어 엔비디아 쿠다(CUDA) 라이브러리 독점을 부수겠다고 강조하며 소프트웨어를 차별화 요소로 내세웠다.

팻 겔싱어 인텔 CEO는 행사 키노트(기조연설)에서 "오늘날 우리가 누리는 모든 것이 반도체 힘(Power of silicon)에서 온다"며 "특정 대기업(엔비디아)이 기업 AI 시스템을 장악하는 것을 관망해서 안 되고 AI 개발을 위한 개방형 생태계를 만들 때"라고 말했다.

그러면서 주요 파트너로 네이버를 소개했다. 겔싱어 인텔 CEO는 네이버를 "자체적으로 초거대언어모델(LLM)을 구축하는 아시아의 대단한 회사"라고 치켜세웠다.

이어 최수연 네이버 대표가 사전 준비한 영상을 통해 "네이버는 전 세계 세 번째로 자체 개발한 LLM을 공개한 회사"라며 "앞으로 인텔과 협력해 효율적인 AI 컴퓨팅 인프라를 마련할 것"이라고 말했다.

이에 따라 네이버의 LLM '하이퍼클로바X' 학습·추론을 위한 인프라 상당 부분이 가우디 기반으로 전환한다. 기존에는 엔비디아와 협력해 만든 슈퍼컴퓨터 '세종'을 활용해 하이퍼클로바X 학습을 진행한 점을 고려하면 회사 차원에서 AI 인프라 공급망을 다각화한 것으로 풀이된다.

하정우 네이버클라우드 AI이노베이션센터장은 키노트 현장에서 "네이버클라우드는 가우디 생태계 확장을 위해 회사 내부에 AI 스타트업·학계와 협력하는 네이버-인텔 공동연구소를 만들었다"며 "네이버클라우드는 가우디 기반으로 LLM 운영 환경을 만들고 이를 다양한 기업과 공공기관에 제공할 계획"이라고 말했다.

인텔은 개방형 생태계 구축을 위해 네이버 외에도 보쉬, IBM 등 글로벌 IT 기업과 협력하기로 했다. 인도의 AI·IT서비스 기업인 올라 크루트림, 인포시스도 함께 한다.

팻 겔싱어 인텔 CEO는 행사 키노트(기조연설)에서 "오늘날 우리가 누리는 모든 것이 반도체 힘(Power of silicon)에서 온다"며 "특정 대기업(엔비디아)이 기업 AI 시스템을 장악하는 것을 관망해서 안 되고 AI 개발을 위한 개방형 생태계를 만들 때"라고 말했다.

그러면서 주요 파트너로 네이버를 소개했다. 겔싱어 인텔 CEO는 네이버를 "자체적으로 초거대언어모델(LLM)을 구축하는 아시아의 대단한 회사"라고 치켜세웠다.

이어 최수연 네이버 대표가 사전 준비한 영상을 통해 "네이버는 전 세계 세 번째로 자체 개발한 LLM을 공개한 회사"라며 "앞으로 인텔과 협력해 효율적인 AI 컴퓨팅 인프라를 마련할 것"이라고 말했다.

이에 따라 네이버의 LLM '하이퍼클로바X' 학습·추론을 위한 인프라 상당 부분이 가우디 기반으로 전환한다. 기존에는 엔비디아와 협력해 만든 슈퍼컴퓨터 '세종'을 활용해 하이퍼클로바X 학습을 진행한 점을 고려하면 회사 차원에서 AI 인프라 공급망을 다각화한 것으로 풀이된다.

하정우 네이버클라우드 AI이노베이션센터장은 키노트 현장에서 "네이버클라우드는 가우디 생태계 확장을 위해 회사 내부에 AI 스타트업·학계와 협력하는 네이버-인텔 공동연구소를 만들었다"며 "네이버클라우드는 가우디 기반으로 LLM 운영 환경을 만들고 이를 다양한 기업과 공공기관에 제공할 계획"이라고 말했다.

인텔은 개방형 생태계 구축을 위해 네이버 외에도 보쉬, IBM 등 글로벌 IT 기업과 협력하기로 했다. 인도의 AI·IT서비스 기업인 올라 크루트림, 인포시스도 함께 한다.

팻 겔싱어 인텔 최고경영자(왼쪽)와 하정우 네이버클라우드 AI센터장이 9일(현지시간) 미국 애리조나주 피닉스에서 열린 인텔 비전 행사에서 양사 협력 방안에 관해 설명하고 있다. [사진=인텔]

![[날씨] 전국 흐리고 눈비…미세먼지는 좋음](https://image.ajunews.com/content/image/2025/03/16/20250316062142985743_388_136.jpg)

![[슬라이드 포토] 故 휘성, 영정 사진 속 환한 미소](https://image.ajunews.com/content/image/2025/03/14/20250314131052257994_518_323.jpg)

![[포토] 홈플러스, 정산 대금 3400억 지급…현금 1600억 보유](https://image.ajunews.com/content/image/2025/03/14/20250314104411947330_518_323.jpg)

![[포토] 최재해 감사원장, 기각 후 업무 복귀](https://image.ajunews.com/content/image/2025/03/13/20250313120924594304_518_323.jpg)

![[포토] 국민의힘, 헌재 앞 기자회견](https://image.ajunews.com/content/image/2025/03/13/20250313120803802996_518_323.jpg)